全文共5806字,预计阅读时间15分钟

作者 | 程韫韵(Emily)

编辑 | 谭舒雯(Poppy)

注:文中图片均来源于网络

前言

在人工智能高速发展的热潮下,庞大的数据量和复杂的算法模型对算力及芯片提出了新的需求。类脑芯片成为近年来学术界和产业界都越来越关注的重点方向,甚至在Gartner的芯片产业预测图中将类脑芯片判断为第三代人工智能芯片。上海新氦类脑智能科技有限公司(以下简称“新氦类脑智能”)就在此背景下诞生,类脑芯片及片上智能系统是新氦类脑智能的研发及商业转化的重点方向。近年来新氦类脑智能看到许多类脑芯片领域的创新突破和科研热潮,因此新氦类脑智能总结了类脑芯片领域的现状、问题和趋势,希望在充满信心的同时保持客观冷静分析,给行业的发展带来一些启发和推动作用。

脑科学与类脑研究

“计算机之父”冯诺依曼通过对人脑和电脑的系统性比较,在他的《自复制自动机理论》一书中提到,生物大脑与机器相比最大的优势是能够利用相对落后的零部件在一个充满随机涨落的高度不确定环境中,以绿色环保的低能耗方式,非常敏捷快速地做出正确计算。[1]

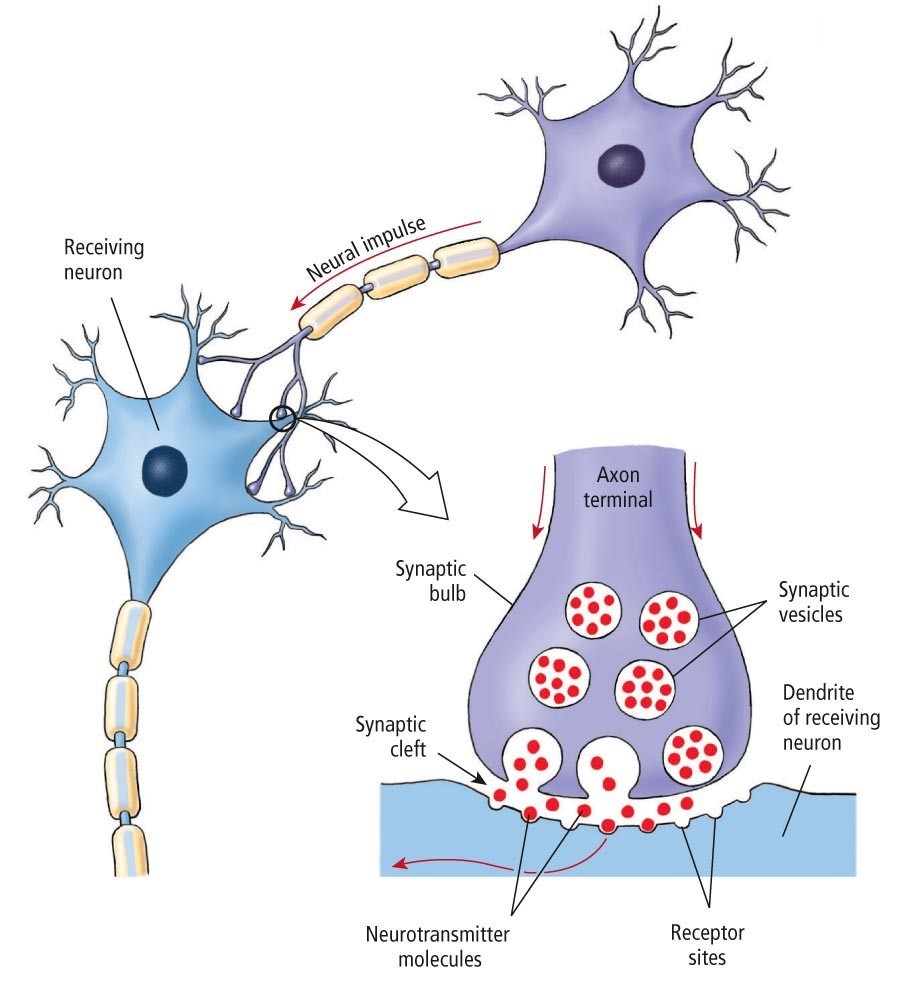

人脑拥有约1000亿个神经元(Neuron)和100万亿个突触(Synapse)。信息传递过程中,神经元细胞膜附近产生动作电位,尖峰沿着轴突传递,到达轴突末端后通过突触释放的化学神经递质传递给下游神经元,并重新转换为电信号(图1)。人脑采用串行以及大规模并行的信息处理模式,能够处理数字和模拟信号,基本运算速度约每秒1000次。

图1 神经元与神经突触

目前,人工智能领域的研究还处在“弱人工智能”阶段,而人脑则相当于“强人工智能”或“通用人工智能”。因此,“类脑”是人工智能的未来发展趋势。相关研究一般有两种“靠近”人脑的路径:功能和结构。

“功能类脑”的前提是理解人脑一系列行为如学习、记忆、感知和意识的生物基础,在此基础上建造人工智能。然而,基于这一路径的人工智能研究进展缓慢,因为首先需要解决的是一个更为复杂的问题,即人脑进行一系列认知行为的原理。

“结构类脑”则是以大脑图谱为蓝图,用微纳器件模拟神经元和神经突触的信息处理传递功能,构造出仿大脑皮层神经网络和生物感知器官的仿生神经网络,然后通过外界刺激使其拥有人工智能。[2]

从已有研究成果来看,这一路径涉及的工程技术问题更有可能在近数十年内取得持续进展和重大突破。瑞典卡罗琳学院的研究人员在2018年8月成功绘制出小鼠神经系统中多种细胞类型的详细图谱,为揭示机体神经性疾病起源提供了线索,这种方法同样可用于人脑的详细图谱绘制。[3]神经形态器件方面,清华大学2019年8月研发出全球首款异构融合类脑计算芯片“天机芯”,有多个高度可重构的功能性核,同时支持机器学习算法和类脑计算算法,为通用人工智能(Artificial General Intelligence)计算平台的发展起到促进作用。 [4]

类脑研究的发展历史

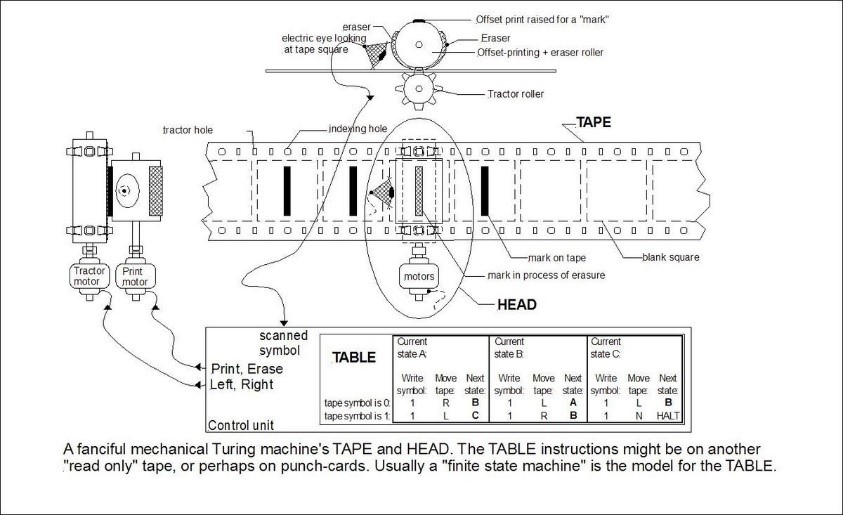

类脑研究可以追溯到1936年Alan Turing在《论可计算数及其在判定问题上的应用》一文中提到一台能够执行任何复杂数学计算的机器,即图灵机(Turing Machine) (图2)。[5]图灵机提供了一个用数值模型检验生物信息处理相关问题的方法,模型的各参数用二进制数表达,还可以与物理模型结合成混合系统以更好地模拟人脑。

图2 图灵机

Warren McCulloch和Walter Pitts于1943年发表的《A Logical Calculus of the Ideas Immanent in Nervous Activity》被认为是神经网络(Neural Network)的开山之作。[6]1949年,在Turing 《Intelligence Machinery》论文发表的一年后,Donald Hebb提出学习和记忆的机制为突触可塑性(Synaptic Plasticity)。可塑性被认为是大脑认知功能的基础, Hebb认为同步的电活动会导致突触增强,而非同步的电活动会使突触前后的连接削弱。[7]生物研究领域,1953年,Horace Barlow在青蛙大脑里发现了对特定视觉刺激做出反应的神经元。[8]几年后,David Hubel和Torsten Wiesel的实验表明猫的初级视皮层神经元能够选择性地对特定方位边界做出反应。[9]这些实验证明了接受域里某一层级细胞的形成来自于更低层级细胞的输入。

1958年,心理学家Frank Rosenblatt定义了连接主义(Connectionism)的理论基础,并研究出一种名为“感知机”(Perceptron)的神经网络模型,能够完 成简单的视觉处理任务。[10]感知机是一种二元线性分类器,也是一种最简单的单层前馈神经网络,区别于较复杂的多层感知机(Multilayer Perceptron)。与生物神经细胞的突触、阈值和细胞体分别对应的概念是权量、偏置和激活函数。Rosenblatt提出的相关算法包括感知机学习(Perceptron Learning Algorithm)、最小二乘法(Least Squares Method)和梯度下降法(Gradient Descent Method)。经实验证明,感知机能够识别出现次数较多的字母,还能对不同书写方式的字母进行概括和归纳,但无法可靠地识别受干扰的字母图像。连接主义又被称为仿生学派,是人工智能三大主流学派之一,主张通过模仿人类神经元和神经网络连接机制实现人工智能。[11]

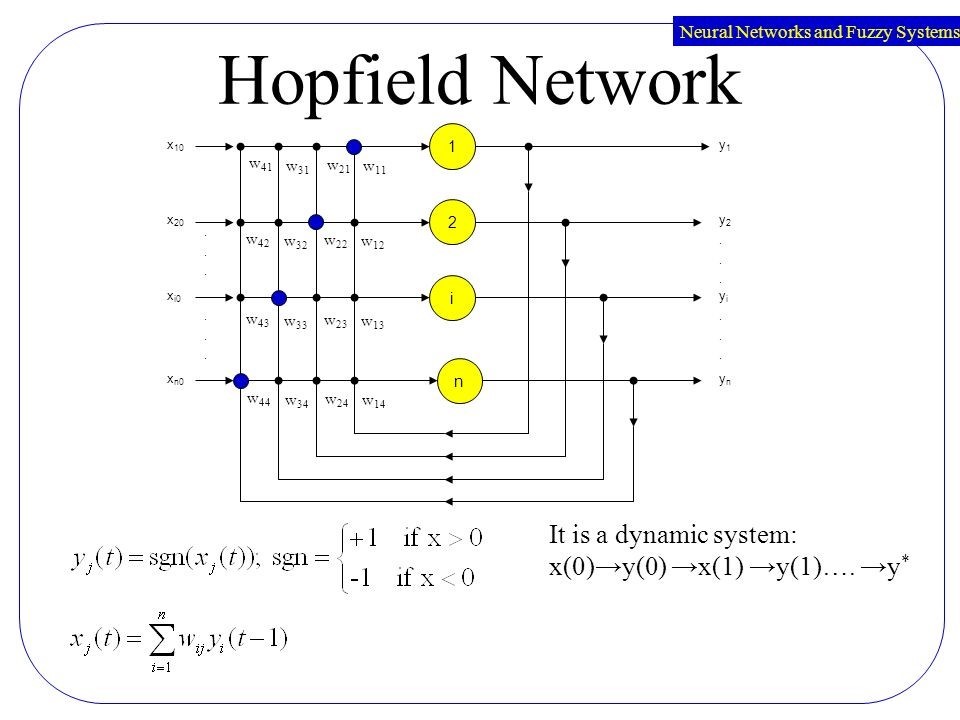

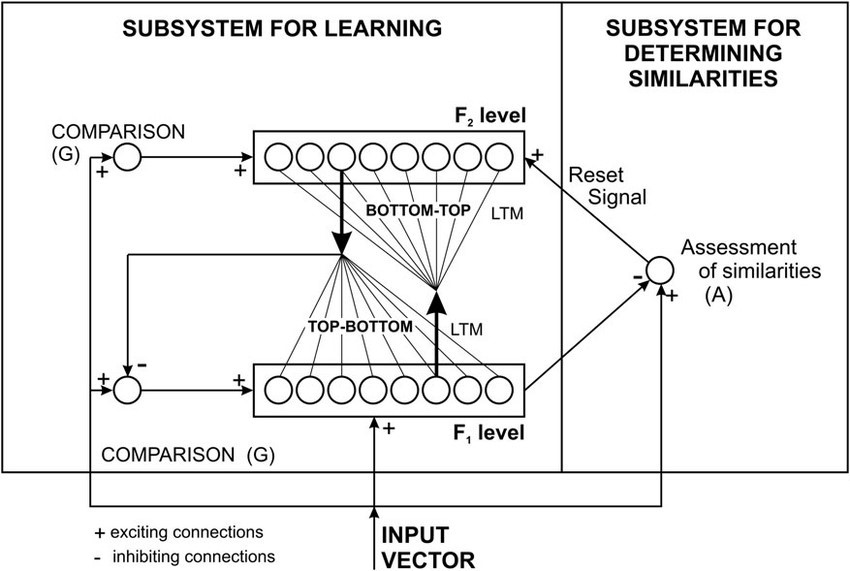

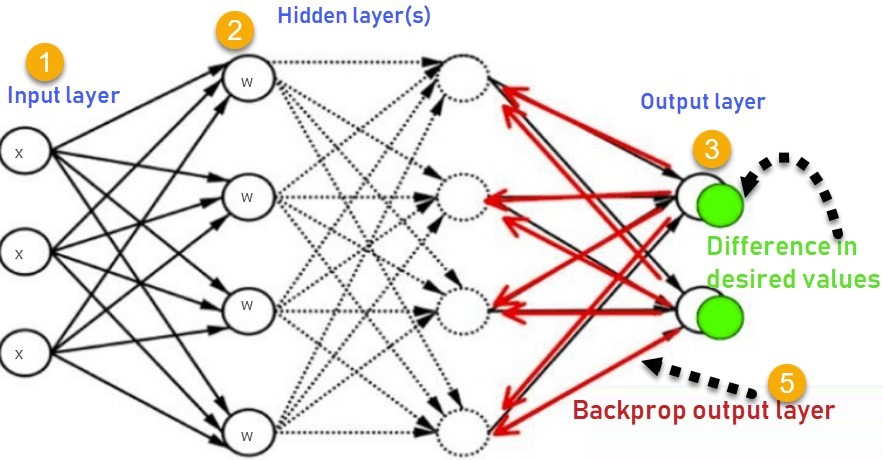

1963年,Alan Hodgkin和Andrew Huxley因为测量出神经元传递电信号的动态过程并给出精确描述这一过程的微分方程(Hodgkin-Huxley Equations)而获得诺贝尔奖。[12]到1969年,感知机的热潮在符号主义学派代表人物Marvin Minsky和Seymour Papert的研究结果发表后逐渐减弱。[13]直到二十世纪八十年代,Hopfield神经网络(图3)[14]、自适应共振理论(Adaptive Resonance Theory)(图4)、反向传播算法(Backpropagation)(图5)等研究成果的发表才让连接主义重新引起关注。

图3 Hopfield神经网络

图4 自适应共振理论

图5 反向传播算法

1971年,Leon Chua基于对称性的假设证明了两端电路元件忆阻器(Memristor)的存在。[15]现代微电子学先驱Carver Mead在1980年发表的论文中首次提出超大规模集成电路(Very-large-scale Integration)的概念,并在1989年发明了世界上第一块拥有人工视网膜和耳蜗的类神经芯片。[16]超大规模集成电路是将大量晶体管组合到单一芯片上的集成电路,例如计算机的控制核心微处理器。超大规模集成电路设计通常采用电子设计自动化方式,设计人员负责电路逻辑功能的硬件描述语言表达形式,而计算机则辅助完成功能验证、逻辑仿真、逻辑综合、布局、布线和版图等。日本政府曾在1976-1980年提出超大规模集成电路计划,旨在激励和组织企业开展创造性的合作研究活动。在日本从传统重工业向知识密集型产业转型的趋势下,VLSI计划被认为对日本半导体行业的国际竞争力提升起了重大作用。人工硅视网膜是一个透光的二维CMOS芯片,上面接收器的位置决定了图像的采样结果。电阻网络的横向扩展对应的结构是水平细胞层,图像信号会经过网络的每一个节点被平行处理。六边形排列可以确保每个接收器之间距离相等,从而得到均衡的图像样本。除此之外,硅视网膜还含有扫描设备以读取经视网膜处理后的图像结果。[17]模拟电子耳蜗涉及CMOS、VLSI和微功率技术。

模型的关键是一系列串联的简单线性二级滤波级和可控Q参数以捕捉耳蜗中流体动力行波系统的物理现象,包括外层毛细胞的有源增益和适应性影响。测试芯片上得到的数据证明了电路从原理和观察结果两方面都与真实耳蜗相匹配。[18]Mead与John Hopfield和Richard Feynman的研究开创了神经形态工程(Neuromorphic Engineering)、计算物理和神经网络等新的研究领域与方向。其中,神经形态工程是利用具有模拟电路的超大规模集成电路来模拟人脑神经系统,其目标是制造出仿真人脑芯片。Mead采用亚阈值的硅来模拟人脑的低功耗处理过程。在极低电压下,亚阈值硅仍有微小的不规则电子流通过晶体管,其大小和可变性与神经回路中的电子流非常相似。与传统芯片不同的是,硅神经元以非数字化的形式运行,其电流和电压并不限于不连续的数值。而神经网络是一种模仿生物神经网络结构和功能的数学或计算模型,是一种能在外界信息基础上改变内部结构的自适应系统,依网络架构可大致分为前馈神经网络,如CNN(卷积神经网络,Convolutional Neural Network),和反馈神经网络,如RNN(递归神经网络,Recurrent Neural Network)。

随后,连接主义学派发明了更简单有效的统计方法如支持向量机(Support Vector Machine)和长短期记忆算法(Long-short Term Memory),有效降低了计算资源的消耗。支持向量机是一种采用监督式学习算法(Supervised Learning)的一般化线性分类器,能够同时最小化经验误差和最大化几何边缘区。

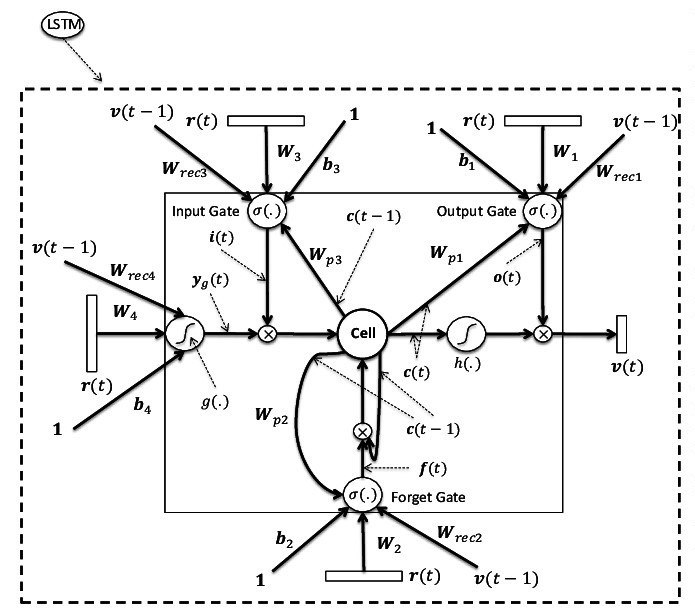

这一算法将向量映射到一个高维空间里,并在这个空间里建立一个最大间隔超平面。超平面两边有两个互相平行的超平面,而分隔超平面能使这两个平行超平面的距离最大化,这时分类器的总误差达到最小值。[19]长短期记忆是一种具有长期记忆能力的时间递归神经网络(图6), 由一个或多个具有可遗忘和记忆功能的单元组成。其重要组成部分包括Forget Gate、Input Gate和Output Gate,分别决定当前输入是否被采纳、是否被长期记忆和记忆中的输入是否在当前被输出。Forget Gate的使用意味着遗忘过程的权重无需清除,突触权重也不必是非易失性的,这样的短期记忆为类脑芯片的重要组成部分忆阻器的发展提供了新方向。[20]

LSTM算法在1997年被提出以解决传统递归神经网络随时间反向传播中权重消失的问题,现在应用于语音识别、自然语言处理、文本压缩和手写文字识别等场景。[21]低能耗和低时延的特性使LSTM忆阻器能够广泛用于边缘推断领域。[22]

图6 长短期记忆算法

到二十一世纪,随着类脑研究在人工智能领域受到的重视日益增长,世界各国纷纷出资建立了相关研究计划,研发出一系列大型神经形态计算系统。2004年,斯坦福大学的Kwabena Boahen团队开发了一种基于AMS(模拟混合信号,Analog Mixed Signal)电路的类脑芯片Neurogrid(图7)。Neurogrid是一个能够实时模拟大规模神经模型的类脑系统,它由16个定制的Neurocore芯片组成,每个芯片能够模拟65,536个神经元。这一系统能够以比私有电脑云快9000倍的速度和十万分之一的能耗一共模拟出一百万个神经元和数以亿计的突触连接。Neurogrid芯片能够模拟人脑中经过神经元筛选的具有多样性的离子信号,通过共享的电子线路强化突触连接,而它的树状结构能有效提升运算速度。Neurogrid芯片目前主要用于脑科学研究,能够被重新编码而拥有与不同皮层相似的行为活动。这一系统旨在降低机器人的能耗,并最终能安全地植入人体以控制仿生手臂。[23]

图7 Neurogrid芯片

2005年,曼彻斯特大学开始进行基于多核ARM(进阶精简指令集机器,Advanced RISC Machine)处理器的SpiNNaker计划,欧盟也开展了名为FACETS的计划,旨在开发AMS类脑芯片。SpiNNaker计划致力于用100万个ARM微处理器建造一个大规模并行计算的超级电脑,电脑的互联结构基于哺乳动物大脑的连接特性,因此能够从生物学角度应用于实时大规模的脉冲神经网络(Spiking Neural Network)。这一计划的创新之处在于通信结构,即对大数量小信息包进行优化。每个通信包都搭载一个单个神经元脉冲事件,包含AER(地址-事件表达编码,Address-event Representation)的神经元识别符和用于识别包类型的管理比特位。这种通信结构能够在低于一毫秒的时间内传输一个通信包,满足了实时神经建模的要求。研究团队希望能够开发出应对抑郁症、阿兹海默症等脑相关疾病的强有力工具。[24]

同年,由美国国防高级研究计划局出资的SyNAPSE(自适应可塑可伸缩电子神经系统,Systems of Neuromorphic Adaptive Plastic Scalable Electronics)项目开始支持IBM的类脑芯片研究。Henry Markram在瑞士洛桑联邦理工学院发起Blue Brain计划,意图用IBM Blue Gene/L超级计算机模拟大规模生物神经网络。三年后,HP实验室研发出首款忆阻器原型和首款CMOS(互补金属氧化物半导体,Complementary Metal Oxide Semiconductor)/忆阻器混合芯片,证明了忆阻器在芯片制造中的重要性。2011年,由欧盟出资的BrainScaleS计划开始实施,旨在研发基于AMS电路的大规模类脑超级计算机。一年后,蓝脑计划成功研发出与蜜蜂大脑规模相似的中央环路模型,拥有约一百万个神经元和十亿个突触。2013年,欧盟全面开展“人脑计划”,建造了包括神经信息学、大脑模拟、高效分析计算、医学信息学、神经形态计算和神经机器人在内的6个研发平台。

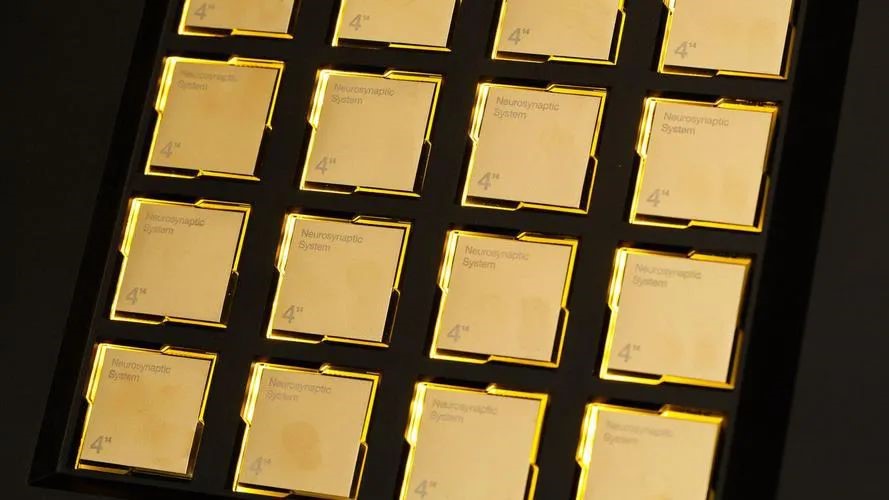

一年后,由Dharmendra Modha带领的SyNAPSE项目团队成功研发出TrueNorth芯片(图8)。这是IBM迄今为止规模最大的芯片,拥有约54亿个晶体管,而能耗只有70mW,是传统处理器的五千分之一。[25]TrueNorth内置4096个内核,100万个“神经元”和2.56亿个“突触”。芯片能够以80%的准确率识别出用30帧每秒的正常速度拍摄的十字路口视频中的人、自行车、公交车和卡车等,比普通电脑快100倍,拥有极高的通信效率。除计算能力外,认知能力也是TrueNorth芯片的强项,IBM希望能将其部署在物联网(Internet of Things)中,通过传感器网络和微型电机网络不断记录和报告数据。 [26]

图8 TrueNorth芯片

类脑芯片的优点

图9 冯诺依曼结构

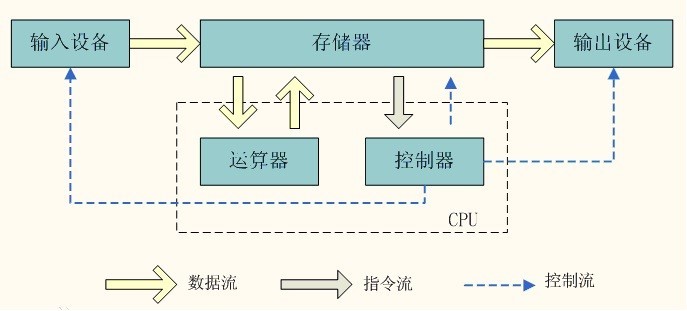

后摩尔时代,晶体管电路的性能逐渐接近极限。随着芯片中晶体管数量的不断增加,电子能量外泄和热量散发的现象逐渐加剧。传统的冯诺依曼结构(图9)面临着存储能力的挑战,CPU利用率限制和存储器与处理器之间数据传输速度导致了高成本。过去几十年中,CPU性能以每年约55%的速度快速提升,而内存性能的提升速度只有约10%,这导致了CPU的运算速度远高于访存速度。冯诺依曼架构将数据和指令放在同一内存中,由于CPU和内存之间数据传输带宽的限制,数据和指令无法同时调取,CPU必须浪费时间等数据。而且随着CPU的更新换代和内存量的不断提升,吞吐量限制问题显得越发严重,这种限制CPU性能发挥的内存存取速度瓶颈也被称为“内存墙”(Memory Wall)。

而拥有“类脑”结构的神经模态计算芯片可以很大程度上解决“冯诺依曼瓶颈”(von Neumann Bottleneck)问题。一方面,类脑芯片“事件驱动”(Event-driven)的特性能够降低功耗。因为计算功耗与输入有关,在输入不会激活大量神经元的情况下,功耗可以达到非常低的水平,可以应用于物联网等领域,而且“突触可塑性”能让芯片拥有更强的自适应学习能力。正如生物神经元信息传递过程中,只有当累积的电信号超过阈值时,动作电位才会沿着轴突传递,其他时间则处于未激活状态。神经模态计算的前馈过程是每个神经元电路模块每被激活一次就发射一个电脉冲,而非直接输出整个前馈过程中的电脉冲。因此,与深度学习(Deep Learning)相比,类脑计算是真正重现生物神经系统的过程。

芯片的另一优势是存算一体(In-memory Computing),直接将信息储存在神经元里,相当于生物神经网络中每个神经元储存的电荷,以此满足特定应用领域如边缘计算低时延的要求。存算一体是一种数模混合的存储计算方式,即在存储器上叠加算法,使存储单元具有计算功能。数据可以直接在存储器中完成计算,而无需单独的计算单元,由此降低了数据访存延迟。人工智能对数模混合一定程度上的精度误差有较高的容忍性,因此存算一体还意味着更高的性能和能效收益。

上下滑动查看文章参考资料:

[1]

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.1029.4814&rep=rep1&type=pdf

Von Neumann’s Self-Reproducing Automata by Arthur W. Burks

[2]

http://zhishifenzi.com/depth/thought/188.html

通向强智能:制造图灵的“童年大脑”

[3]

https://www.cell.com/cell/fulltext/S0092-8674(18)30789-X

Molecular Architecture of the Mouse Nervous System by Amit Zeisel, etc.

[4]

https://www.nature.com/articles/s41586-019-1424-8

Towards Artificial General Intelligence with Hybrid Tianjic Chip Architecture by Jing Pei, etc.

[5]

https://www.cs.virginia.edu/~robins/Turing_Paper_1936.pdf

On Computable Numbers, with an Application to the Entscheidungsprobelm by A.M. Turing

[6]

https://www.cs.cmu.edu/~./epxing/Class/10715/reading/McCulloch.and.Pitts.pdf

A Logical Calculus of the Ideas Immanent in Nervous Activity by Warren S. McCulloch and Walter Pitts

[7]

https://pdfs.semanticscholar.org/f9fc/99a5c52aa5df1b530dfdeb25dfb6b10bdecf.pdf Hebbian Leaning and Plasticity by Wulfram Gerstner

[8]

https://physoc.onlinelibrary.wiley.com/doi/epdf/10.1113/jphysiol.1953.sp004829

Summation and Inhibition in the Frog’s Retina by H. B, Barlow

[9]

http://centennial.rucares.org/index.php?page=Neural_Basis_Visual_Perception

The Neural Basis of Visual Perception

[10]

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.335.3398&rep=rep1&type=pdf

The Perceptron: A Probabilistic Model for Information Storage and Organization in the Brain by F. Rosenblatt

[11]

https://pdfs.semanticscholar.org/7994/423929d321794a3ed7450c488c5950540f2f.pdf

A Brief History of Connectionism by David A. Medler

[12]

https://www.math.mcgill.ca/gantumur/docs/reps/RyanSicilianoHH.pdf

The Hodgkin-Huxley Model: Its Extensions, Analysis and Numerics by Ryan Siciliano

[13]

https://leon.bottou.org/publications/pdf/perceptrons-2017.pdf

Perceptrons: An Introduction to Computational Geometry by Marvin L. Minsky and Seymour A. Papert

[14]

https://www.doc.ic.ac.uk/~sd4215/hopfield.html

Introduction to Hopfield Neural Networks by Sixte De Maupeou

[15]

https://www.radioeng.cz/fulltexts/2015/15_02_0319_0368.pdf

Everything You Wish to Know about Memristors but are Afraid to Ask by Leon Chua

[16]

http://ai.eecs.umich.edu/people/conway/VLSI/VLSIText/PP-V2/V2.pdf

Introduction to VLSI Systems by Carver A. Mead and Lynn A. Conway

[17]

https://link.springer.com/chapter/10.1007/978-1-4615-2724-4_2

The Silicon Retina by Misha Mahowald and

[18]

https://ieeexplore.ieee.org/abstract/document/1639

An Analog Electronic Cochlea by R.F. Lyon and C. Mead

[19]

https://towardsdatascience.com/support-vector-machine-introduction-to-machine-learning-algorithms-934a444fca47

Support Vector Machine - Introduction to Machine Learning Algorithms by Rohith Gandhi

[20]

https://aip.scitation.org/doi/pdf/10.1063/1.5037835

Perspective: A Review on Memristive Hardware for Neuromorphic Computation by Changhyuck Sung, Hyunsang Hwang and In Kyeong Yoo

[21]

https://www.bioinf.jku.at/publications/older/2604.pdf

Long Short-Term Memory by Sepp Hochreiter and Jurgen Schmidhuber

[22]

https://www.nature.com/articles/s42256-018-0001-4.pdf

Long Short-Term Memory Networks in Memristor Crossbar Arrays by Can Li, etc.

[23]

https://singularityhub.com/2014/05/16/neurogrid-a-circuit-board-modeled-on-the-human-brain/

NeuroGrid – A Circuit Board Modeled after the Human Brain

[24]

https://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=6750072

The SpiNNaker Project by Steve B. Furber

[25]

A survey of neuromorphic computing based on spiking neural networks

[26]

http://www.research.ibm.com/articles/brain-chip.shtml

声明:本文章发布目的在于传递更多信息,并不代表本公众号赞同其观点和对其真实性负责。如涉及作品内容、版权和其它问题,请及时与我司联系,我们将在第一时间处理!

作 者 介 绍

/程 韫 韵 Emily/

拥有多年跨区域、跨行业的企业战略咨询经验,在AI技术及应用领域拥有丰富的经验和深入洞察。秉持对AI浓厚的学习兴趣和认真钻研态度,对人工智能基础技术及实际应用两方面都有深入研究,为AI创业团队和企业高管分析行业发展趋势,出具专业咨询建议。曾主导撰写AI技术白皮书,总结并判断未来AI技术的热点发展方向。

沪公网安备 31011002003093号

沪公网安备 31011002003093号